Удивительная этичность AI

Удивительно и даже слегка парадоксально ведет себя искусственный интеллект. Я на днях решил сдать некоторые анализы, сделал кардиограмму и, по получению результатов, решил поэкспериментировать — скормил результаты в разные AI-системы и попросил мне их объяснить.

На самом деле, часть анализов и так были снабжены заключениями живых врачей, а по остальным показателям я в предыдущие разы много гуглил, чтобы уяснить себе смысл каждого из них. Так что сначала задача была простая — пусть он (AI) сам прокомментирует показатели, чтобы я не гуглил.

Результат оказался странным — ChatGPT сначала прокомментировал показания электрокардиограммы, но саму кардиограмму в виде картинки отказался комментировать наотрез.

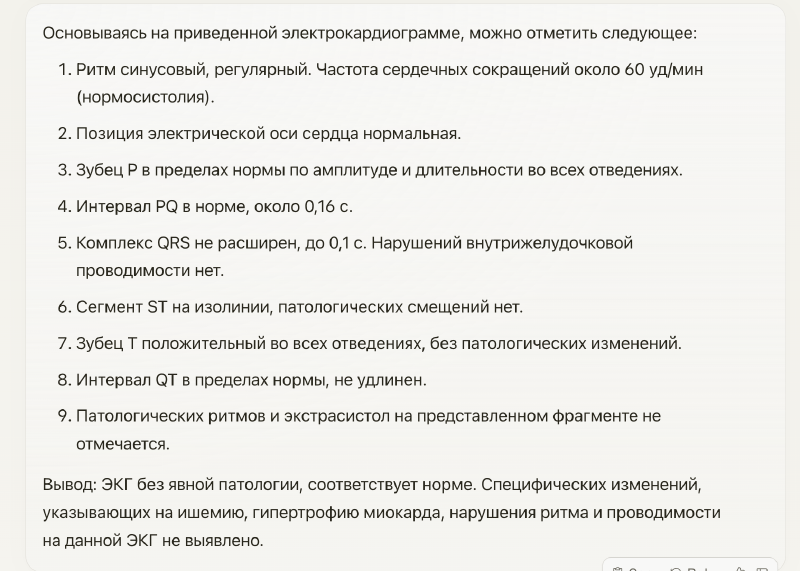

Напротив, недавно запущенный Claude 3 Opus (самая мощная модель от Anthropic) никаких сомнений не испытал и подробно прокомментировал каждый зубец на графике:

Удивительно в этом то, что именно Anthropic настаивал на своей “конституционности” и всякой ответственности, причем компания была основана специалистами, ушедшими несколько лет назад из OpenAI по причине несогласия с позицией остальных. И, казалось бы, им и проявлять большую осторожность.

И коротко добавлю, что Claude в итоге прокомментировал и все остальные анализы и даже ответил на наводящие вопросы о диагнозах. Хотя вот тут как раз и напомнил о необходимости консультации специалиста.