Зачем нужна национальная LLM

Full disclosure: Этот текст комментирует интервью одного из руководителей Минцифры Украины в области AI. Я участвовал в конкурсе на должность Chief AI Officer, который полгода назад проводило Минцифры.

На ДОУ опубликовано интервью с Дмитрием Овчаренко, CTO центра AI, недавно организованного Министерство цифровой трансформации, посвященное в основном вопросу разработки национальной LLM. Эта разработка была анонсирована при запуске центра и, честно скажу, сразу вызвала у меня недоумение. Интервью это недоумение совершенно не развеяло, скорее усилило.

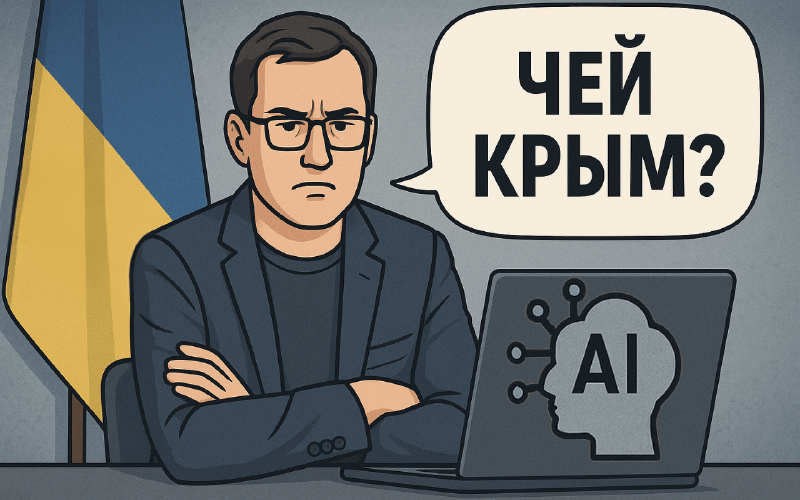

Ну, смотрите — перечисляются причины, по которым Украине нужна своя LLM и первой называется «Культурное значение». Причем с конкретным примером — модель должна «правильно» отвечать на вопрос «Чей Крым?». Я бы понял, если бы такое сказал политик или какой-нибудь блогер в комментариях. Но ведь интервью даёт, кажется, технический специалист, причем, видимо, следящий за новостями. У нас реально есть цель повторить подвиг разработчиков DeepSeek, чья модель отказывается обсуждать события 1989 года в Пекине и на кого похож Винни Пух?

Вполне понимаю резоны, связанные с конфиденциальностью и безопасностью — действительно, не годится выгружать в облако государственную информацию, тем более, что большинство облак находится в стране, где прямо сейчас естественный интеллект ушел в отпуск. Но эту задачу решают многие бизнесы по всему миру и мало кто приходит к идее «Сначала обучим свою LLM».

Совершенно верно — в мире существует несколько примеров LLM, объявленных национальными. За редкими исключениями это разработки стран, языки которых плохо поддерживались большинство существующих решений — речь идет об арабском, тюркских языках, японском, то есть довольно далеко отстоящих от аналитического английского, который наиболее прост для токенизации и машинной обработки. Этим странам, в общем-то, и деваться некуда — любое многоязычное решение будет работать с их языками плохо и/или дорого, а любое собственное, ориентированное на пары типа английский/арабский или английский/японский, будет эффективнее.

Да, украинский язык, как любой флективный, имеет развитую морфологию и просто в силу этого любая модель в тексте на украинском будет видеть больше токенов, чем в его дословном переводе на английском. Если добавить ограничения словаря, то вылезают довольно забавные вещи — например, слово «London» — это один токен, а слово «Odessa» — два. А вот «Odesa» — это три токена (все примеры даны по токенайзеру GPT-4).

Но надо же понимать разницу между положением Саудовской Аравии, Сингапура, Японии и Украины. У них есть проблема с поддержкой основного языка практически во всех существующих моделях и нет проблемы с финансированием. У нас ситуация примерно обратная — украинский достаточно хорошо поддерживается в большинстве моделей, пусть и не оптимально, но денег нет совсем — собственно, об этом прямо упоминается в интервью. Более того, нет датацентров, нет GPU, нет даже электроэнергии.

Что же тогда собрались разрабатывать? Вот тут государственный деятель предельно откровенен — еще не собрались. То есть буквально — «продолжается этап формирования концепции, определяем задачи, формируем структуру, оцениваем бюджет и ищем партнеров». В том числе — тех, кто денег даст.

Давайте я вам сразу скажу, что это будет. Возьмут Llama, причем, как уже определились, достаточно малые модели (от 1 до 17B), наверное, обучат свой токенайзер, и займутся дообучением модели на украинских датасетах. Тут будет, насколько я понимаю, масса работы на массу времени — я последние три месяца занимаюсь таким специфическим украинским корпусом и периодически чувствую себя то Гераклом в конюшнях, то старателем на Юконе.

Но знаете, в чем будет проблема? Полученная в результате такого тяжкого труда своя LLM будет проигрывать по всем тестам совершенно привычной GPT-4o, не говоря уже о reasoning моделях. И причин тому две — во-первых, большие проприетарные модели уже знают всё то, что разработчики будут собирать и скармливать Llama (впрочем, возможно, они возьмут Gemma), и во-вторых, модель на триллионы параметров всегда будет отвечать лучше, чем модель на 17 миллиардов, пусть и с излишним количеством токенов.

К слову сказать, бог с ней, с GPT, не факт, что дообученная украинская LLM на базе Llama-17B будет выигрывать у открытой же Llama-405B (пардон, уже вроде можно приводить в пример Llama-4-Behemoth). Причем по той же причине — большая модель просто уже знает большую часть того, что будет использоваться для дообучения маленькой, а разница слишком невелика, чтобы её можно было увидеть невооруженным глазом.

Я не раскрываю никаких секретов или тайн, если что — подобные соображения вполне доступны любому, кто потратит некоторое время и усилия на изучение AI. И поэтому каждый мог бы задуматься — а зачем это всё?

Нет, ну правда. Если вы хотите иметь в своем распоряжении всю мощь нынешнего AI — есть готовые проприетарные решения. Если вам критична конфиденциальность — возьмите готовую модель, котору можно развернуть локально, или компромиссное решение типа той же mT5, имеющей хорошую поддержку украинского. Если вы хотите обеспечить условный технологический суверенитет — начните с обеспечения энергетической безопасности и добычи GPU по умеренным ценам. Но если вы начинаете рассказывать про историков и культурных деятелей, которые будут собирать политически выдержанный датасет — вы явно не развитием AI собрались заняться.

Я бы мог заподозрить, что весь этот проект является распилом — взять пример с Польши, которая планирует бухнуть в развитие AI миллиард злотых, много и бесполезно тренировать модели, покупая дорогие GPU. Но тут денег нет и, скорее всего, даже заявленной суммы в миллионы долларов проект может не собрать. Поэтому обиднее всего, что это даже не ради денег — а ради политического пиара, чтобы несколько человек могли регулярно рассказывать про формирование концепции, определение структуры и привлечении специалистов и общественности к решению грандиозной проблемы — чтобы несколько строчек кода умели выдавать ответ на вопрос «Чей Крым?».

Потому что, если бы хотелось что-то сделать для, например, решения проблемы качества информации в многочисленных реестрах, то взяли бы уже готовые модели и начали их реальное применение, заодно собирая вылезающие проблемы и формируя требования к той же будущей национальной модели, доказывая тем самым её необходимость. А если структуру запускают с готовым решением «Написать всё свое», то вопроса о задачах не стоит, конечно.